مقدمه

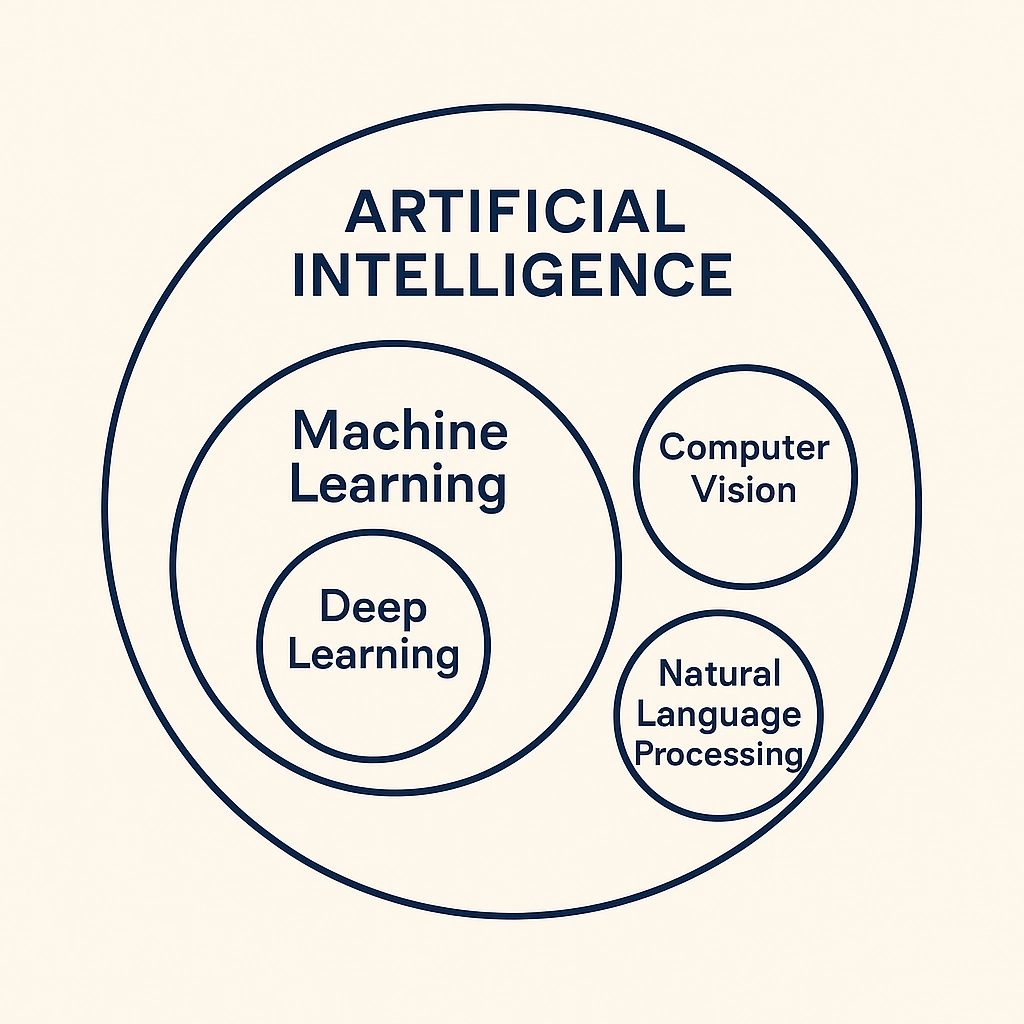

فناوری هوش مثنوعی یا Artificial Intelligence که به اختصار AI نامیده میشود، در قلب بسیاری از فناوریهایی است که هر روز با آنها سر و کار داریم، از موتورهای جستوجو گرفته تا خودروهای خودران. این تکنولوژی به سرعت در حال تغییر دادن نحوه کار، زندگی و تصمیمگیری ماست. هوش مصنوعی به ماشینها و سیستمها این امکان را میدهد که مانند انسانها فکر کنند، یاد بگیرند و عمل کنند. این فناوری به ماشینها اجازه میدهد که از دادهها یاد بگیرند، الگوها را شناسایی کنند و تصمیمات هوشمندانه بگیرند. AI شامل زیرشاخههای مختلفی از جمله یادگیری ماشین (ML)، یادگیری عمیق (DL) و پردازش زبان طبیعی (NLP) است. در این پست، نگاهی دقیقتر میاندازیم به ماهیت، کاربردهای فعلی، چالشها و مسیر پیش روی هوش مصنوعی.

هوش مصنوعی چیست؟

در سال 1956 در کنفرانس دارتموث آقای جان مککارتی و همکارانشان برای اولین بار از اصطلاح هوش مصنوعی استفاده کردند. این کنفرانس با هدف بررسی امکان ساخت ماشینهای هوشمندی که بتوانند مانند انسان فکر کنند، برگزار شده بود. این موضوع برای جندین دهه به دستمایهای برای ساخت فیلمهای علمی تخیلی تبدیل شده بود. فیلمهایی مانند The Matrix که جهان ما را به صورت یک شبیهسازی به تصویر میکشد که ماشینها بر آن حکومت میکنند یا فیلم Transcendence که در آن یک دانشمندِ در حال مرگ، ذهنش را به یک کامپیوتر منتقل میکند.

اما در دهههای اخیر، هوش مصنوعی به یک واقعیت تبدیل شده است و توسعه الگوریتمهای یادگیری ماشین و یادگیری عمیق، هوش مصنوعی را به مهمترین فناوری عصر حاضر تبدیل کرده است. این فناوری به ماشینها این امکان را میدهد که از دادهها یاد بگیرند، الگوها را شناسایی کنند و تصمیمات هوشمندانه بگیرند.

با این حال، خیلی از مسائل و موضوعات مطرحشده در فیلمهای علمی تخیلی، همچنان فکر

انسانها را مشغول کرده است. آیا واقعاً ما در معرض خطر انقلاب ماشینها قرار داریم؟

مرز بین انسان و ماشین کجاست؟ آیا ماشینها میتوانند احساسات انسانی را درک کنند؟

آیا ممکن است ماشینها در خلاقیت و احساس از انسان پیشی بگیرند؟ پدیدههایی مثل آپلود ذهن تا چه حد شدنی به نظر

میرسند؟

برای پرداختن به این سوالات باید قبل از هر چیز با ماهیت هوش مصنوعی آشنا شویم.

یعنی باید بدانیم این فناوری ماهیتاً چیست و چطور کار میکند؟

با وجود ظاهر جادویی، هوش مصنوعی در واقع، متکی به آمار و الگوریتمهای ریاضی مشخصی موسوم به الگوریتمهای

یادگیری ماشین (Machine

Learning) است.

یادگیری ماشین

یادگیری ماشین (ML) از تکنیکهای بِیزی (Bayesian techniques) برای شناسایی الگو و یادگیری استفاده میکند. این تکنیکها از دادهها برای یادگیری و پیشبینی استفاده میکنند. ML ماشینها را قادر میکند که دادهها را طبقهبندی کنند و الگوها را از دادهها استخراج کنند. میتوانید اینطور به قضیه نگاه کنید که از روی مجموعهای از دادههای ورودی و خروجی، تابع ریاضی مورد نظر تخمین زده شده و به این ترتیب، امکان پیشبینی خروجیهای جدید با استفاده از ورودیهای جدید فراهم میشود.

قضیه بیز و تکنیکهای بیزی

تکنیکهای بیزی مجموعهای از روشهای آماریِ مبتنی بر قضیهی کلاسیک بیز است که در قرن هیجدهم توسط ریاضیدان مشهور انگلیسی Thomas Bayes ارائه شد. فضیهی بیز به احتمالات شرطی و نحوهی محاسبهی احتمال رخ دادن یک رویداد به شرط رخ دادن یک رویداد دیگر، مربوط است. این قضیه و تکنیکهای منتج از آن، در حوزههای متعددی مانند داروسازی، رباتیک و یادگیری ماشین کاربرد دارند.

پس، رابطه بین هوش مثنوعی و یادگیری ماشین را میتوانیم اینطور بیان کنیم که: هوش مصنوعی یک مفهوم کلیتر است که هدفش ایجاد یک سیستم هوشمند است و یادگیری ماشین یکی از مهمترین ابزارها برای رسیدن به این هدف است که دادهها را تحلیل میکند، الگوهای موجود در آنها را شناسایی میکند و از آنها یاد میگیرد.

به عنوان یک مثال ساده، فرش کنید میخواهیم ماشینی داشته باشیم که بتواند ایمیلهای اسپم را تشخیص دهد. برای این کار، میتوانیم از یک الگوریتم یادگیری ماشین استفاده کنیم که با استفاده از دادههای آموزشی، الگوهای موجود در ایمیلهای اسپم را شناسایی کند. این الگوریتم میتواند با استفاده از ویژگیهایی مانند کلمات کلیدی، فرمت و ساختار ایمیلها، الگوهای موجود در ایمیلهای اسپم را شناسایی کند و سپس با استفاده از این الگوها، ایمیلهای جدید را طبقهبندی کند. به این ترتیب، ماشین میتواند ایمیلهای اسپم را شناسایی کند و آنها را از ایمیلهای عادی جدا کند. خودِ فرآیند یادگیری کاملاً به دادهها وابسته است. یعنی ماشین باید تعداد زیادی از ایمیلهای اسپم و نرمال را ببیند و از روی آنها یاد بگیرد که چه ویژگیهایی باعث میشود که یک ایمیل اسپم باشد یا نباشد.

یادگیری عمیق

یادگیری عمیق (Deep Learning) یا DL زیرمجموعهای از یادگیری ماشین (ML) است که با استفاده از مجموعهای از الگوریتمهای لایهای، به ماشینها کمک میکند که دادهها را بهتر درک کنند. در حقیقت، DL به ماشینها امکان میدهد که مانند انسانها بتوانند از روی مثالها یاد بگیرند. این تکنولوژی DL است که امکان تولید اتومبیلهای خودران را ممکن کرده و به آنها امکان میدهد که بتوانند علائم راهنمایی را درک کنند و یا انسان را از تیر چراغ برق تشخیص دهند.

الگوریتمهای DL از مجموعههای بزرگی از دادههای آموزشی برای شناسایی روابط بین عناصری مانند اَشکال، کلمات و رنگها استفاده میکنند. این روابط به الگوریتمهای DL برای پیشبینی کمک میکنند. الگوریتمهای DL میتوانند بسیاری از روابط (از جمله روابطی که شاید توسط انسان تشخیص داده نشوند) را شناسایی کرده و دادههای بسیار پیچیده را تفسیر یا پیشبینی کنند.

پس، یادگیری عمیق، همانطور که از نامش پیداست، یک زیرشاخهی پیشرفتهتر از یادگیری ماشین است که به یادگیری ماشین عمق میدهد و آن را قادر به شناسایی الگوهای پیچیدهتر میکند. تکنولوژی تشخیص چهره، ترجمه آنی زبانها، سیستمهای رانندگی خودکار و چتباتهایی مثل ChatGPT تعدادی از کاربردهای یادگیری عمیق هستند.

بینایی ماشین

بینایی کامپیوتر (Computer Vision) سیستمها و کامپیوترها را قادر به درک ورودیها میکند. در حقیقت، بینایی کامپیوتر زیرشاخهای از هوش مصنوعی است که روی فعالکردن دید مصنوعی در ماشینها متمرکز است. این زیرشاخه شامل آموزش ماشینها برای تشخیص و استخراج معنا از ورودیهای بصری مانند تصاویر و ویدیوهای دیجیتال است. ماشینها میتوانند بر اساس این اطلاعات، اقدامی انجام دهند یا توصیهای ارائه دهند.

بینایی کامپیوتر مشابه بینایی انسان عمل میکند. به جای استفاده از شبکیه، قشر بینایی و عصب بینایی، ماشینها از دوربینها، الگوریتمها و دادهها برای پیادهسازی مکانیزم بینایی استفاده میکنند. برای مثال، بینایی کامپیوتر، ماشینها را قادر میسازد تا بین اجسام تمایز قائل شوند، فاصلهی بین آنها را محاسبه کنند و حرکت یا سکون آنها را تشخیص دهند.

پردازش زبان طبیعی

پردازش زبان طبیعی (Natural Language Processing) یا NLP کامپیوترها و سیستمها را قادر میکند که متن و گفتار را درک کنند. NLP زیرشاخهای از هوش مصنوعی است که ماشینها را آموزش میدهد تا زبان انسان را به اَشکال مختلف از جمله متن و صوت پردازش کنند و از این ورودی، معناهایی از قبیل تمایل و احساس را استخراج کنند.

NLP شامل استفاده از زبانشناسی محاسباتی (مدلسازی مبتنی بر قوانین انسانی) در کنار یادگیری ماشین، یادگیری عمیق و مدلهای آماری است. برنامههای کامپیوتری مجهز به NLP میتوانند متون را به زبانهای مختلف ترجمه گنند، دادههای بزرگ را به سرعت خلاصه کنند و به دستورات گفتاری پاسخ دهند.

کاربردهای هوش مصنوعی

هوش مصنوعی در صنایع مختلف از جمله بهداشت و درمان، مالی، خودروسازی، خردهفروشی و سرگرمی کاربرد دارد. در زیر به برخی از کاربردهای هوش مصنوعی اشاره میکنیم:

- پزشکی: تشخیص بیماریها و پیشبینی روند درمان، تحلیل تصاویر پزشکی، رباتهای جراح

- مالی: تشخیص تقلب، مشاوره مالی، تحلیل دادههای مالی و پیشبینی بازار

- حمل و نقل: خودرانها و سیستمهای رانندگی خودکار، مدیریت هوشمند ترافیک

- صنعت: بهینهسازی تولید، پیشبینی خرابی ماشینآلات، رباتهای صنعتی

- سرگرمی: تقلید صدا، فیلترهای چهره، پیشنهاد فیلم و موسیقی

آینده هوش مصنوعی بسیار تحولآفرین پیشبینی میشود. آنچه که مسلم است، گسترش و بهبود بسیاری از ابزارهای فعلی AI است. تولید محتوا با استفاده از AI به کیفیت بالاتری خواهد رسید و به زودی متن و ویدیوهای با کیفیت انسانی توسط AI تولید خواهد شد. به علاوه، در آینده شاهد ادغام روزافزون سیستمهای AI با سیستمهای دیگر مانند اینترنت اشیا یا IOT خواهیم بود و یکی از نتایج این ادغام، ساخت شهرهای هوشمند و خانههای خودکار خواهد بود (خانهی هوشمند سریال روزی روزگاری مریخ پیمان قاسمخانی را دیدهاید؟)

اما فراتر از همه اینها در آینده شاهد ظهور هوش عمومی مصنوعی (AGI) خواهیم بود. AGI به ماشینها این امکان را میدهد که درست مانند انسانها فکر کنند و یاد بگیرند. و باز هم فراتر از آن، حتی انگارههایی مثل آپلود ذهن در کامپیوتر هم از نظر تئوری ممکن است و با وجود چالشها و ابهامات فروانی که در این مسیر وجود دارد و فارغ از وجوه فلسفی چنین عملی، احتمال رسیدن به شکلی از آن در آینده وجود دارد، البته در آیندهای دور و شاید در قرنهای آینده.

مدلهای استقرار هوش مصنوعی

برای استقرار (deployment) الگوریتمهای هوش مصنوعی چند راه متداول وجود دارد: استقرار از طریق پلتفرمهای ابری، استقرار در لبه (at the Edge) و از طریق اینترنت اشیاء (IOT).

هوش مصنوعی در فضای ابری (Cloud AI)

هوش مصنوعی به خودکارسازی کارها در زیرساختهای IT کمک کرده و باعث افزایش بهرهوری میشود. ترکیب هوش مصنوعی

با

پردازش ابری (Cloud Computing) یا CC شبکهای انعطافپذیر تولید میکند که میتواند دادههای گستردهای را در

خود نگه دارد و به طور مداوم بهبود یابد. شرکتهای پیشرو در ارائهی خدمات ابری، ابزارهای هوش مصنوعی را برای

مشتریان سرویسهای ابری خود ارائه میدهند.

مزایای پیادهسازی هوش مصنوعی در فضای ابری عبارتند از:

- کاهش هزینهها: پردازش ابری، هزینههای نگهداری زیرساختهای هوش مصنوعی را حذف میکند و به شرکتها و کسبوکارها امکان میدهد که به ابزارهای هوش مصنوعی بر اساس مدل پرداخت به ازای میزان استفاده، دسترسی داشته باشند.

- کارهای خودکار: سرویسهای ابری مبتنی بر هوش مصنوعی میتوانند کارهای تکراری را که نسبت به کارهای خودکار سنتی به هوش و پیچیدگی بیشتری نیاز دارند، انجام دهند. این اتوماسیون، بهرهوری را افزایش داده و در عین حال، نیروی انسانی را کاهش میدهد.

- بهبود امنیت: هوش مصنوعی به ایمن کردن برنامهها و دادهها در فضای ابری کمک میکند و ابزارهای قدرتمندی برای ردیابی، تجزیه و تحلیل و رسیدگی به مسائل امنیتی ارائه میدهد. به عنوان مثال، تجزیه و تحلیل رفتاری میتواند رفتار غیرعادی را تشخیص دهد و به تیمهای امنیتی هشدار دهد.

- بینشهای مبتنی بر داده: هوش مصنوعی الگوهای موجود در دادههای حجیم را شناسایی میکند تا بینش عمیقتری را در مورد فرایندهای اخیر و قبلی به کارکنان IT ارائه دهد. این امر به کارکنان امکان میدهد که سریعتر به مشکلات رسیدگی کنند.

- قابلیتهای مدیریت پیشرفته: هوش مصنوعی میتواند دادهها را پردازش، سازماندهی و مدیریت کند تا مدیریت زنجیره تأمین، بازاریابی و سایر دادههای تجاری سادهتر شود.

هوش مصنوعی در لبه (Edge AI)

هوش مصنوعی لبه (Edge AI) الگویی برای ایجاد جریانهای کاری هوش مصنوعی است که هم دیتاسنترهای متمرکز و هم دستگاههای مستقر در نزدیکی افراد و اشیاء فیزیکی را در بر میگیرد. Edge AI با رویکرد رایج توسعه و اجرای کامل برنامههای هوش مصنوعی در فضای ابری متفاوت است و از طرف دیگر با توسعهی سنتی هوش مصنوعی که در آن سازمانها الگوریتمهای هوش مصنوعی را ایجاد میکنند و آنها را روی سرورهای متمرکز مستقر میکنند نیز متفاوت است. در Edge AI، الگوریتمها مستقیماً روی دستگاههای کاربران نهایی مستقر میشوند.

در مدل Edge AI هر دستگاه لبه عملکرد هوش مصنوعی مختص خود را دارد و معمولاً بخش مشخصی از دادهها را ذخیره میکند. البته دستگاه لبه میتواند به خدمات ابری برای عملکردهای خاص دسترسی داشته باشد اما با این حال، قادر است بیشتر عملکردها را به طور مستقل و با تأخیر بسیار کم انجام دهد.

Edge AI پتانسیل فوقالعادهای برای بهبود عملکرد دستگاههایی مانند تلفنها، وسایل نقلیهی خودران و رباتها دارد. با تزریق هوش مصنوعی به این دستگاههای لبهای میتوان از نوآوریهای هوش مصنوعی برای کاهش تأخیر، کاهش هزینههای ذحیرهسازی و بهبود امنیت به شکل کارامدتری استفاده کرد.

هوش مصنوعی برای اینترنت اشیاء (AIOT)

هوش مصنوعی برای اینترنت اشیاء (AIOT) فناوریهای هوش مصنعی (AI) را با زیرساخت اینترنت اشیاء (IOT) ترکیب میکند تا عملیات اینترنت اشیاء کارامدتر شده و تعاملات بین انسان و ماشین و مدیریت دادهها بهبود داده شود. AI میتواند برای تبدیل دادههای اینترنت اشیاء به اطلاعات کاربردی، بهبود فرایندهای تصمیمگیری و بسترسازی برای فناوریهای جدید به کار رود.

AIOT به AI امکان میدهد که از طریق قابلیتهای یادگیری ماشین به IOT ارزش بیشتری بدهد و در مقابل، IOT از طریق اتصال، سیگنالها و تبادل دادهی بلادرنگ (real time) به AI ارزش میبخشد.

در مدل استقرار AIOT، هوش مصنوعی در اجزای زیرساخت مستقر در دستگاههای IOT که به شبکه اینترنت اشیاء متصل هستند، تعبیه شده و سپس، از APIها برای گسترش قابلیت همکاری بین اجزا در سطوح دستگاه، نرمافزار و پلتفرم استفاده میشود.